MCP 协议通过 Serverless 架构实现安全高效的 AI 应用落地。弹性算力解决算力瓶颈,简化部署流程,加速 AI 应用开发。

原文标题:谁是MCP 的 AI 好搭档?

原文作者:阿里云开发者

冷月清谈:

怜星夜思:

2、Serverless 架构为 MCP 提供了弹性算力,但同时也带来了一些挑战,例如冷启动问题。你认为未来有哪些技术可以进一步优化 Serverless 在 MCP 应用中的性能?

3、文章提到了阿里云函数计算 FC 已经内置了 MCP 运行时,并提供了一键部署模版。你认为未来云厂商还可以在 MCP 生态建设方面做哪些工作,以进一步降低开发者的使用门槛?

原文内容

随着 AI 技术的飞速发展,MCP(模型上下文协议) 逐渐崭露头角。这项由 Anthropic 公司(Claude 的创造者)于 2024 年 11 月推出的开放协议,正在重新定义 AI 与数字世界的交互方式。这项开放协议不仅让 AI 突破传统对话边界,更赋予其执行现实任务的能力,堪称人工智能向"行动智能体"进化的里程碑。然而从火热概念到落地业务,MCP 还需要找到云端“好搭档”。

从 LLM 到 MCP 的进化之路

悬崖跳舞 or 火山口野餐?

从传统 LLM 到 MCP 的进化之路,本质上是一场关于数据交互安全的范式革命。

在传统的 AI 应用中,语言模型在处理用户数据时,开发者往往面临非此即彼的困境:要么像传统聊天场景那样将数据全量上传至云端(但面临隐私泄露风险和数据规模限制),要么赋予模型 Open Interpreter 式的本地管理员权限(可能因恶意代码执行导致系统沦陷)。这种"全有或全无"的安全策略,就像让用户选择在悬崖边跳舞还是在火山口野餐。

然而 MCP 协议的出现从根本上解决了用户的两难困境:MCP 协议的突破性在于构建了智能交互的标准范式。通过标准化的通信协议,它在模型与数据源之间建立了安全隔离带。想象一下,当你用 LLM 分析财务数据时,MCP 允许模型像外科医生一样通过标准接口"零接触式"实施“远程手术”。这意味着既不需要将敏感报表上传至云端,也不必开放整个本地文件系统。这种设计类似操作系统的沙箱技术,不可信进程或不可信代码必须运行在虚拟环境,通过隔离的上下文环境访问受限数据,从而减少被攻击面。

但是,过多的安全设计往往会带来开放性的损失,MCP 优化了安全的风险,也需考虑开发者的“开放性”诉求。

从风格各异到风格统一

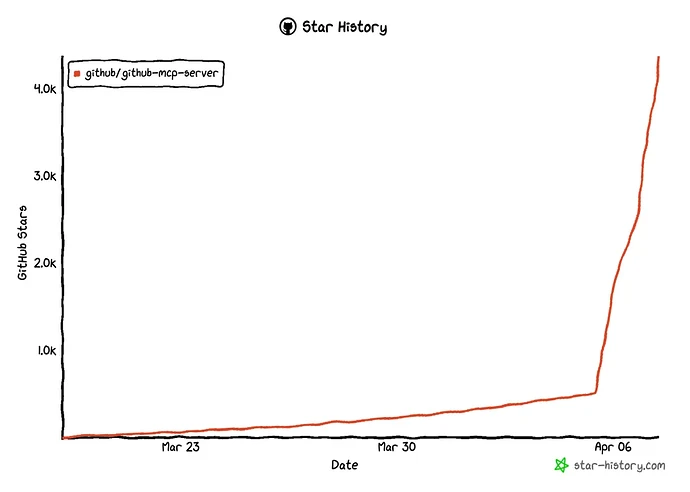

MCP 将不同工具开发者的“个人风格”抽象为统一接口,就像为 AI 世界制定了通用的 USB-C 规范。无论是本地 SQL 数据库还是云端 API,开发者只需实现标准协议即可对接,这显著降低了工具开发和智能体集成工具的边际成本。SaaS 厂商和独立开发者将最先从 MCP 的“开放性”受益,MCP 的火热也为这批成功的“尝鲜者”带来巨大的访问流量激增。根据统计,Github MCP Server 的 star 数 2 周内从 0 增长到 4.3k,Figma MCP Server 的 star 数 6 周内从 0 增长到 4.4k。

但是,MCP 仍只是智能应用的过程工具,MCP 要走向智能体,协助智能体完成任务协作。

爆火之后,算力成新问题

MCP 降低了智能体接入工具的门槛。以近期大火的 OpenManus(4周内 star 从 0 到 40k) 为例,不同于大模型“大而全”的响应模式,OpenManus 的特点是极简可插拔框架,通过模块化、可扩展的工具集,以 ReAct 模式,以工具为核心驱动 Agent 的行动,逐步解决复杂的真实世界问题。在 OpenManus 这套多模型、多工具的设计方案中,工具调用的频次由大模型结合提示词进行“规划→分配→执行”,调用热点不可预测,一旦出现热点工具算力层面不足而产生报错/卡顿现象,将会极大降低 OpenManus 智能体的任务协作效率。

Serverless 解决算力不足的「破窗效应」

Serverless:

MCP 落地的“最佳搭档”

其技术协同性体现在三个维度:

弹性扩展与按需计费:MCP 服务天然适配 Serverless 的事件驱动模型。例如当 LLM 发起数据库查询时,函数计算即时冷启动执行 SQL 解析,响应完成后立即释放资源。实测数据显示,这种模式相比常驻容器节省 83% 的计算成本。

安全沙箱与零信任架构:Serverless 的临时执行环境完美契合 MCP 服务的安全隔离需求。每个 MCP 请求都在独立的上下文中处理,执行完毕后自动销毁实例,消除传统常驻服务的上下文残留,降低数据泄露风险。

生态集成与敏捷交付:阿里云 Serverless 平台已内置 MCP 运行时。开发者通过函数计算 FC 控制台可直接部署预置的 MCP 模版,如函数计算的 "amap-maps-mcp-server" 模版可在 30 秒内完成和高德地图的服务对接。

这种组合正在重塑 AI 应用架构。某出行科技公司的实践显示,其基于 FC+ MCP 构建的智能体系统,在应对突发流量时展现出显著优势:当流量波动引发工具调用洪峰(QPS 从 50 激增至 2000),系统在 500 毫秒内自动扩展出 200 个可并行执行的 MCP 函数实例,全程未触发任何限流告警。这印证了 Serverless 作为 MCP "弹性算力"的核心价值 - 让 MCP 既具备协议标准的统一性,又拥有云原生的弹性基因。

立即体验:

一键部署热门 MCP Server

接下来您可以跟着教程快速实现开源 MCP Server 一键托管,假如您搭建的 AI Agent 中需要加入导航服务,您可能会需要高德社区提供的 MCP Server ,接下来我们将以开源项目 amap-maps-mcp-server 为例演示如何一键部署 MCP Server 到函数计算 FC 上,后续您可以在不同工具(如 Cherry-Studio、Cline 和 Cursor)中继续配置云端 MCP 服务。

第一步: 模版部署

点击【1】进入CAP控制台。填入从高德开发者申请的 Token(立刻申请完成),可以在【2】申请。

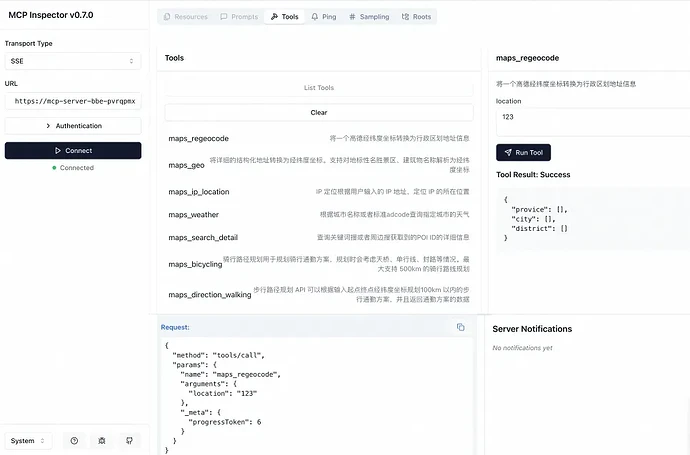

第二步: 测试 MCP Server 提供的工具能力

部署成功之后,通过触发器页面,拿到测试 URL 可对当前 MCP Server 进行测试。如果希望将部署的 MCP Server 用于生产,建议使用自定义域名代替测试 URL。

测试步骤一:本地终端运行命令

npx @modelcontextprotocol/inspector

测试步骤二:浏览器中打开本地提供的测试地址“http://localhost:5173/#tools”进行测试,在 URL 表单中填入上面获取的 URL,添加 /sse 后缀填入 URL 表单中,点击 Connect 会看到开源 MCP Server 提供的 Tools 列表,可以点击置顶 Tool 进行交互验证。

如果您对于产品有更多建议或者对 MCP server 云端托管有更多想法可以加入钉钉群(群号:64970014484)与我们取得联系。

更多开源 MCP Server 一键部署

|

MCP 开源地址

|

编程语言

|

一键部署

|

Server 类型

|

|

https://github.com/baidu-maps/mcp/tree/main/src/baidu-map/node

|

Node

|

https://cap.console.aliyun.com/create-project?template=start-mcp-nodejs-baidu-map

|

mcp-proxy

|

|

https://github.com/modelcontextprotocol/servers/tree/main/src/github

|

Node

|

https://cap.console.aliyun.com/create-project?template=start-mcp-github

|

mcp-proxy

|

|

https://github.com/modelcontextprotocol/servers/tree/main/src/everart

|

Node

|

https://cap.console.aliyun.com/create-project?template=start-mcp-ever-art

|

mcp-proxy

|

|

https://github.com/modelcontextprotocol/servers/tree/main/src/fetch

|

Python

|

https://cap.console.aliyun.com/create-project?template=start-mcp-fetch

|

mcp-proxy

|

|

https://github.com/modelcontextprotocol/servers/tree/main/src/brave-search

|

Node

|

https://cap.console.aliyun.com/create-project?template=start-mcp-brave-search

|

mcp-proxy

|

|

https://github.com/modelcontextprotocol/servers/tree/main/src/time

|

Python

|

https://cap.console.aliyun.com/create-project?template=start-mcp-time

|

mcp-proxy

|

|

https://github.com/devsapp/amap-maps-mcp-server

|

Node

|

https://cap.console.aliyun.com/create-project?template=start-mcp-amap-maps

|

mcp-proxy

|

|

https://github.com/modelcontextprotocol/servers/tree/main/src/everything

|

Node

|

https://cap.console.aliyun.com/create-project?template=start-mcp-everything

|

sse

|

|

https://github.com/modelcontextprotocol/servers/tree/main/src/aws-kb-retrieval-server

|

Node

|

https://cap.console.aliyun.com/create-project?template=start-mcp-aws-kb-retrieval-server

|

mcp-proxy

|

|

https://github.com/modelcontextprotocol/servers/tree/main/src/gitlab

|

Node

|

https://cap.console.aliyun.com/create-project?template=start-mcp-gitlab

|

mcp-proxy

|

|

https://github.com/modelcontextprotocol/servers/tree/main/src/puppeteer

|

Node

|

https://cap.console.aliyun.com/template-detail?template=start-mcp-puppeteer

|

sse

|

|

https://github.com/modelcontextprotocol/servers/tree/main/src/sequentialthinking

|

Node

|

https://cap.console.aliyun.com/create-project?template=start-mcp-sequentialthinking

|

mcp-proxy

|

[1]https://cap.console.aliyun.com/create-project?template=start-mcp-amap-maps

点击阅读原文,立即体验~