牛津博士论文强调,在实际应用中,持续深度学习需要考虑计算成本。研究提出了多种方法,旨在提升模型效率和适应性。

原文标题:【牛津博士论文】考虑计算成本的可扩展持续深度学习

原文作者:数据派THU

冷月清谈:

这篇牛津博士论文着眼于持续学习领域,指出现有研究范式的局限性,并提出更贴近实际应用的解决方案。论文强调在有限计算资源下优化学习的重要性,并展示了简单算法的有效性。研究者们通过通用问题定义、持续表示学习挑战、引入计算约束、无存储约束在线持续学习、快速适应指标以及利用网络监督数据等多个方面,为更高效、更实用的持续学习方法奠定了基础。论文批判了现有指标的缺陷,并改进了数据收集方法,旨在提升持续模型在现实场景中的效率和适用性,最终目标是推动持续学习技术更好地服务于实际应用。

怜星夜思:

1、论文里提到了“即使是不使用在线数据流的简单消融实验,也能匹配或超越为特定持续学习场景设计的算法”,这是否意味着我们在设计算法时过度关注了复杂性,而忽略了简单方法的潜力?

2、论文中提到需要重新评估如何设计和训练模型以实现有效的持续学习, 你认为未来持续学习算法的发展方向是什么?除了论文中提到的,还有哪些潜在的提升方向?

3、论文提到利用网络监督数据进行持续学习。你认为这种方法有哪些潜在的风险和挑战?如何才能更有效地利用互联网上的海量数据?

2、论文中提到需要重新评估如何设计和训练模型以实现有效的持续学习, 你认为未来持续学习算法的发展方向是什么?除了论文中提到的,还有哪些潜在的提升方向?

3、论文提到利用网络监督数据进行持续学习。你认为这种方法有哪些潜在的风险和挑战?如何才能更有效地利用互联网上的海量数据?

原文内容

来源:专知本文约1000字,建议阅读5分钟

本论文为更高效计算的持续学习方法奠定了基础,并倡导其更适合实际应用的发展方向。

持续学习(Continual Learning, CL)是一个新兴领域,专注于开发能够从不断流入的数据流中持续学习的模型,而不是在静态、精选的数据集上进行数百次训练。这些模型旨在保留先前获得的知识,同时无缝整合新信息,通常还受到存储容量等限制。为了推动这一领域的发展,我们首先指出了当前研究范式的局限性,并通过以下方式解决这些问题:(1)实施更现实的约束,例如在有限计算资源内优化学习;(2)展示简单直接算法的有效性。此外,我们解决了现有指标的缺陷,并改进了数据收集方法,以提高持续模型在实际场景中的效率和适用性。

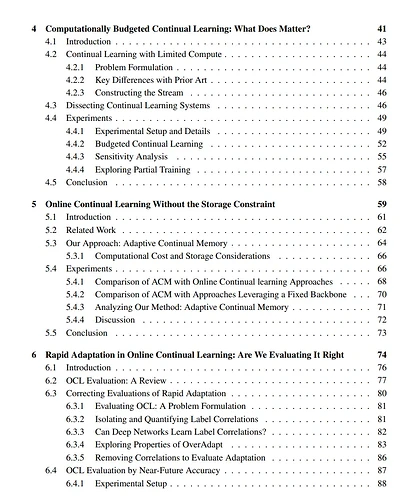

我们的主要贡献如下:

-

通用问题定义与在线数据流相关性的关注:我们提出了一个受开放集识别问题启发的CL分类问题通用定义,要求模型从数据流中持续适应新类别。我们详细说明了持续学习中的一些假设可能过度简化问题,从而降低了其实际相关性。我们的GDumb模型表明,即使是不使用在线数据流的简单消融实验,也能匹配或超越为特定持续学习场景设计的算法,挑战了该领域的进展。

-

持续表示学习的挑战:我们的RanDumb模型通过使用固定的随机变换和简单的线性分类器探索持续表示学习,揭示了不使用表示学习的方法在各种标准持续学习基准上优于使用深度网络的持续学习表示。这一发现表明,我们需要重新评估如何设计和训练模型以实现有效的持续学习。

-

引入计算约束:当前文献通常忽略计算和时间预算的实际约束,而专注于无限制的数据访问。我们开发了大规模数据集(如ImageNet2K和Continual Google Landmarks V2),并在计算受限的设置下广泛评估持续学习,结果表明传统的CL方法即使通过策略性采样和蒸馏也无法超越简单的经验回放基线。这表明现有的CL方法在实际应用中计算成本过高。

-

无存储约束的在线持续学习:我们提出了一种简单的算法,使用固定的预训练特征提取器持续更新kNN分类器,适用于数据流快速变化且计算预算极低的场景。该方法在保持低计算和存储需求的同时,显著优于现有方法的准确性。

-

在线持续学习中的快速适应指标:我们批判了在线持续学习中使用的传统指标。我们的研究结果表明,现有方法可能并未真正适应数据,而是记忆了无关的数据模式。我们通过提出一种专注于“近未来”样本准确性的新指标来解决这一问题,避免学习虚假标签相关性,更好地反映模型真正适应新数据的能力。

-

利用网络监督数据:为了解决持续获取大规模标注数据的不切实际性,我们引入了一种新的持续数据获取范式,允许模型仅使用类别名称适应新类别。我们提出了一种使用未经筛选的网络监督数据的简单方法,不仅减少了对昂贵人工标注的依赖,还展示了互联网数据支持有效学习的潜力。我们创建的EvoTrends数据集以最低的成本反映了现实世界的趋势。

总的来说,本论文为更高效计算的持续学习方法奠定了基础,并倡导其更适合实际应用的发展方向。